Mistral Large,Le Chat来了!Mistral AI连放两个大招!

2月26日,因为开源8x7B Mistral模型而名声大噪的Mistral AI推出了自家的新旗舰大语言模型 Mistral Large。在推理能力方面,可以与 GPT-4 和 Claude 2 等其他顶级模型相媲美

深度学习自然语言处理 原创

作者:pp

此外,Mistral AI还推出了自己基于 Mistral Large 的新服务 Le Chat (https://chat.mistral.ai/chat)作为 ChatGPT,Claude 2 以及 Gemini 的竞品,目前只需邮箱注册即可免费使用

Mistral Large 的特点:

母语是流利的英语、法语、西班牙语、德语和意大利语,对语法和文化背景有细致入微的理解。

其32K 标记上下文窗口允许从大型文档中精确调用信息。

其精确的指令遵循(Instruction-following)能力使开发人员能够设计他们的审核策略——这也是 le Chat 的系统级审核的基础。

它本身就能够进行函数调用。这与在 la Plateforme 上实施的受限输出模式一起,实现了大规模应用程序开发和技术堆栈现代化。

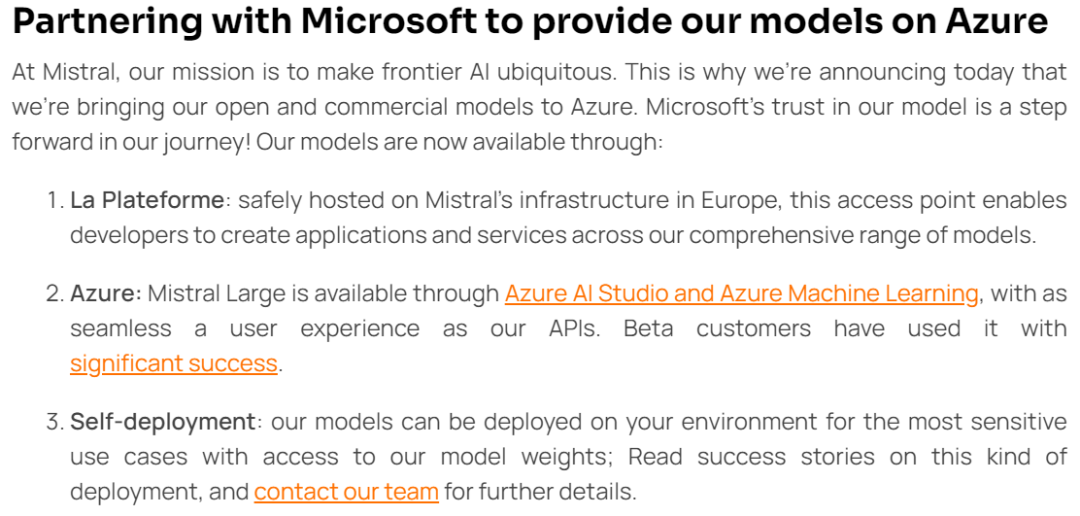

与 Microsoft 合作在 Azure 上提供服务

Mistral 宣布与微软进行合作,现在可以通过以下方式获得模型:

La Plateforme:开发人员能够在该平台上接触到所有模型并创建应用程序和服务。

Azure:Mistral Large 可通过Azure AI Studio 和 Azure Machine Learning 使用,并提供与 API 一样丝滑的用户体验。

自我部署:Mistral 模型可以部署在您的环境中,用于最私人化的应用,并可以访问模型权重;阅读此类部署的成功案例,并联系Mistral AI团队。

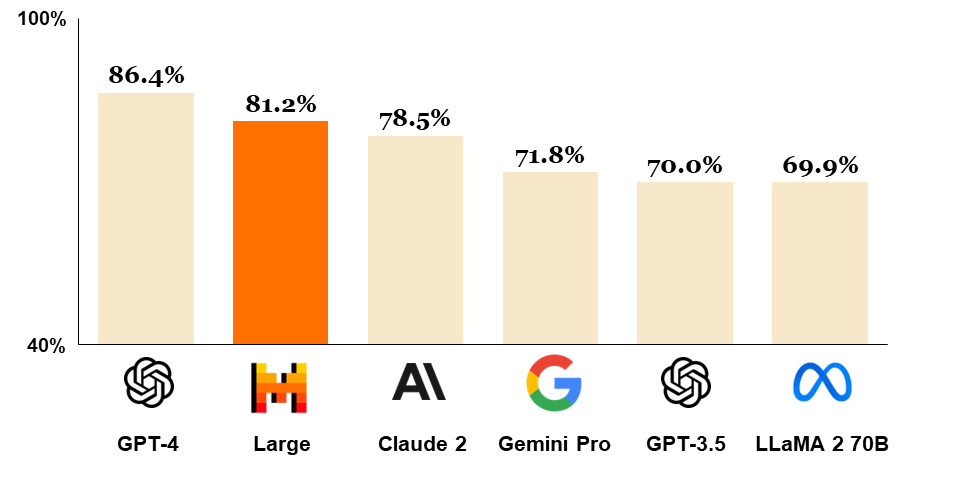

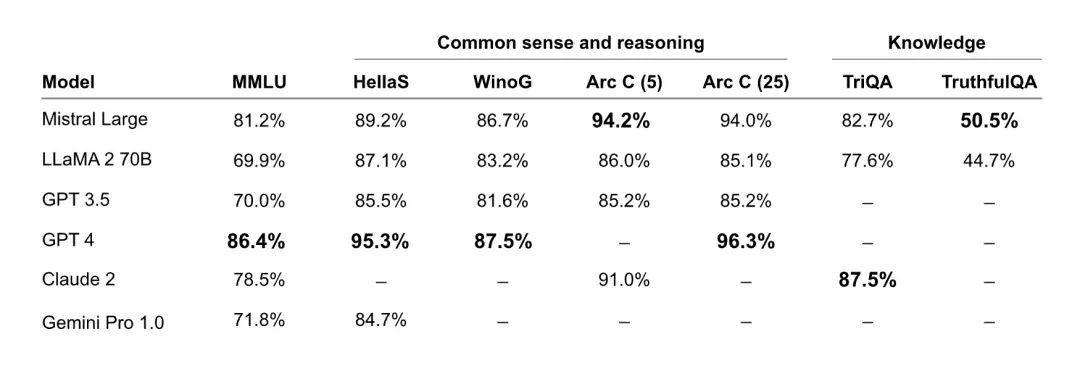

目前主流大模型评测任务测试

团队将 Mistral Large 在常用基准上的性能与顶尖的 LLM 模型进行比较。涵盖推理和知识,多语言能力,数学与代码能力。

全新 Mistral Small,针对低延迟工作负载进行了优化

除了 Mistral Large 之外,Mistral 还发布了一个新的优化模型 Mistral Small,针对延迟和成本进行了优化。Mistral Small 的性能优于 Mixtral 8x7B,并且延迟较低,这使其成为 Mistral AI 的开放权重的模型和旗舰模型之间的中间解决方案。

Mistral Small 受益于与 Mistral Large 在 RAG 启用和函数调用方面相同的创新。我们正在简化我们的 endpoint offering 以提供以下内容:

具有竞争力的开放权重 endpoints。这包括 open-mistral-7B 和 open-mixtral-8x7b。

新的优化模型 endpoints,包括 mistral-small-2402 以及 mistral-large-2402. 我们正在维护 mistral-medium,但本次更新不包含。

试玩Le Chat (部署Mistral Large)

介绍自己 介绍PPO算法

介绍PPO算法

杂谈

Mistral AI 的商业模式看起来越来越像 OpenAI 的商业模式,因为该公司通过付费 API 提供基于使用量的 Mistral Large。默认情况下,Mistral AI 支持 32k 个词组的上下文窗口(在英语中一般超过 20,000 个单词)。目前 Mistral Large 的费用为每百万输入tokens 8 美元,每百万输出tokens 24 美元。作为比较,目前使用 32k 标记上下文窗口的 GPT-4 的成本为每百万输入tokens 60 美元,每百万输出 tokens 120 美元。因此,Mistral Large 目前比 GPT-4-32k 便宜 5 到 7.5 倍。

参考资料

[1] https://mistral.ai/news/mistral-large

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦